신경 방사 필드(NeRF)를 활용한 Object VR

Zip-NeRF + Object VR = Google Shopping

요즘 인공지능이 핫 하다. Open AI의 ChatGPT를 잘 활용하고 있지만, 필자에게는 신경 방사 필드 NeRF(Neural Radiance Fields) 가 가장 마음에 든다.

최근 들어 Nvidia, Google, Meta는 NeRF에 투자하고 있으며, 3D 콘텐츠 렌더링과 관련하여 신경 방사 필드 NeRF는 미래의 핵심 렌더링 기술이기 때문이다.

NeRF는 3D 모델링에 사용되는 기존의 방법과는 다르다. 기존 방법은 3D 모델을 만들기 위해 수많은 이미지를 촬영하고 이를 이용하여 3D 모델을 만드는 것이었지만, 신경 방사 필드(NeRF)는 2D 이미지가 아닌 3D 공간에 있는 물체의 실제 속성을 모델링할 수 있기 때문이다. 이를 위해 레이어 트레이싱(Layer tracing) 기법을 사용하여 빛의 경로를 추적하고, 그 결과로 물체의 입체적인 모습과 빛의 반사, 굴절, 그림자 등을 모두 반영할 수 있습니다.

아래 내용은 이전 시장에도 있었지만 불편함을 줄이기 위해 Google 기사를 보고 알고 있는 내용을 정리한 것이다.

검색 엔진 Google은 신경 방사 필드(Neural Radiance Fields)기술을 활용하여 쇼핑 분야에서 360도 제품을 제공하고 있습니다.

이 서비스는 현재 미국 내 모바일 사용자를 대상으로 제공되고 있으며, 이후 시장을 확대할 것이라 생각됩니다. 사용자들은 6개의 이미지 컷을 통해 매끄러운 모델을 자세히 살펴볼 수 있습니다.

이를 통해 기존의 제품 구매 방식에서 발생하던 불편함을 크게 줄일 수 있을 것으로 보입니다.

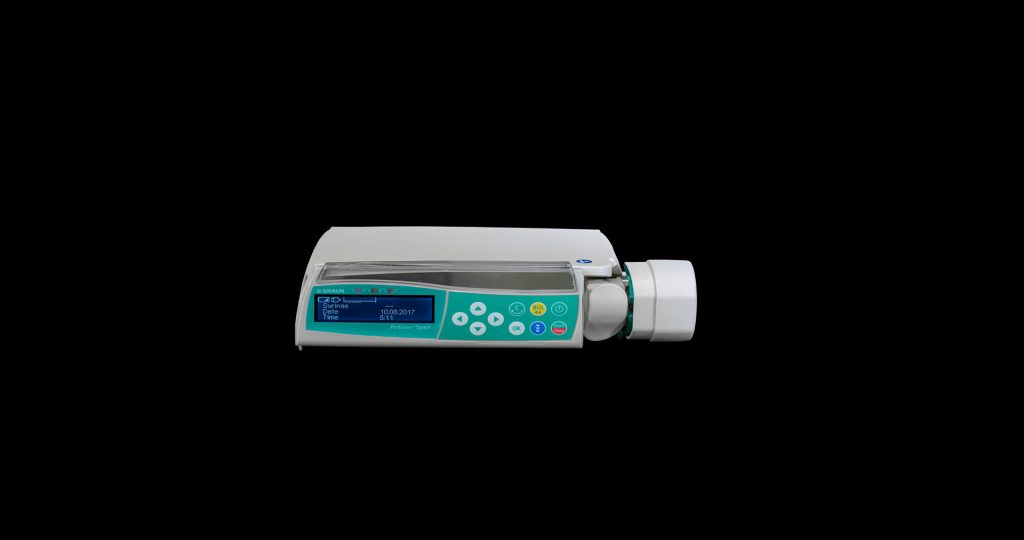

기존의 Object VR 기술은 회전을 부드럽게 보여주기 위해 수십, 수백장의 사진을 사용하고, 개발자들이 직접 Viewer를 제작하여 서비스를 제공했습니다.

그러나 이러한 방식은 사진 촬영 및 최적화를 하지 않을 경우 매끄럽지 않은 구 동력으로 인한 끊김 현상이 발생할 수 있습니다. 또한, 프레임 사이즈를 작게 할 경우 디테일이 떨어져서

메리트가 없을 것이라 생각합니다.

문제는 사진 촬영 및 최적화를 하지 않을 경우 매끄럽지 않은 구 동력으로 끊김 현상이 발생한다. 프레임 사이즈를 작게 할 경우 끊김 현상은 없어지겠지만 디테일이 떨어지기 때문에 메리트가 없을 것이라 생각한다.

2017년 당시에는 36장의 사진을 촬영하여 객체 외 누끼를 따내서 서비스한 제품이 있었습니다. (이미지를 클릭하면 Viewer로 볼 수 있습니다.)

아래 링크는 구글이 2022년 9월 암시적으로 쉽게 쇼핑을 할 수 있는 기능 및 도구 내용이다. 당시 몇 달 안으로 자동화 내용을 언급 한 적이 있다.

신경 방사 필드 기술인 NeRF(Neural Radiance Fields)을 활용한 연구들이 이어지면서, 최근(2023년 4월) 구글에서는 Anti-Aliased Grid-Based Neural Radiance Fields 기술인 Zip-NeRF를 발표했습니다. 이 기술은 시장을 바꿀 만큼 혁신적인 기술로 평가 받고 있습니다.

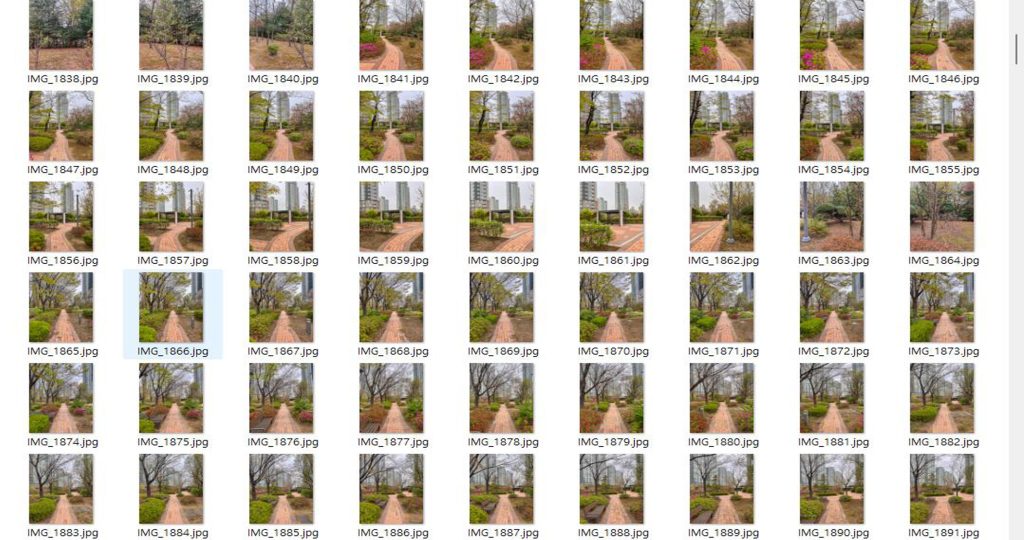

2D 이미지를 3D로 만들기 위해서는 사진 측량(Photogrammetry) 또는 3D 스캐닝 기술을 사용해야 합니다. 두 기술 각각의 장단점이 있겠지만, 스캐너는 고가의 장비와 숙련된 기술자가 필요하며, 사진 측량은 상대적으로 접근성이 용이합니다.

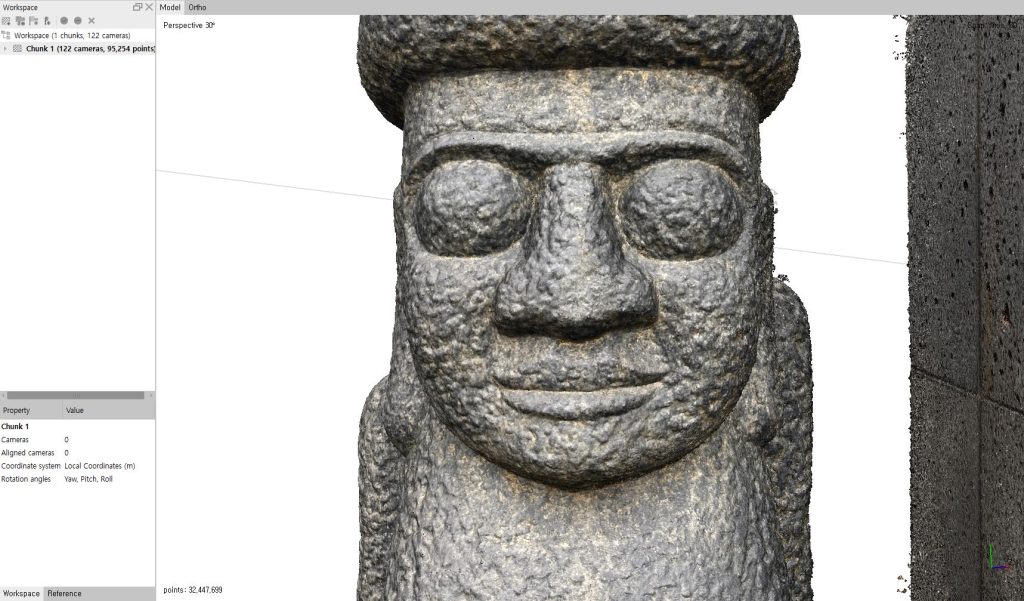

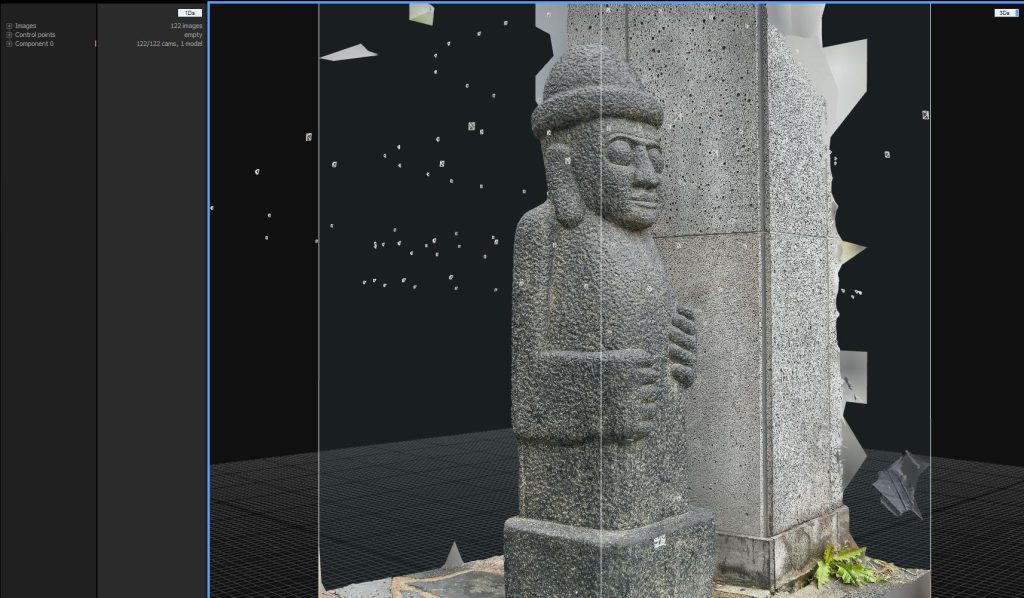

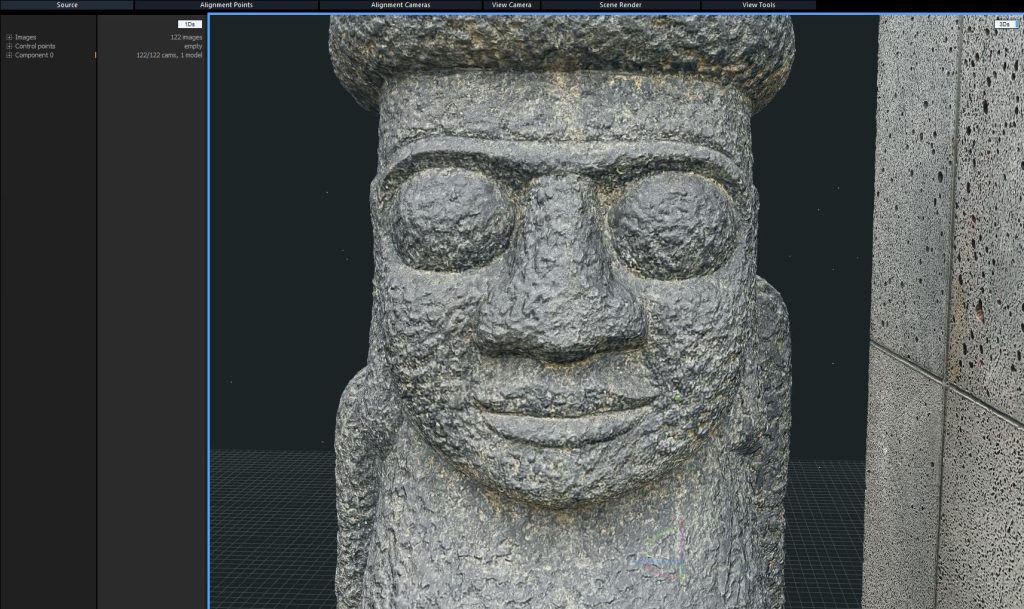

2018년 스캐너(FARO)를 활용한 결과물입니다.

- Project Page: https://jonbarron.info/zipnerf/

Zip-NeRF: Anti-Aliased Grid-Based Neural Radiance Fields

2년 전 NeRF가 등장하면서 3D 공간을 쉽게 만들 수 있는 가능성에 대해 작년부터 관심을 가졌습니다.

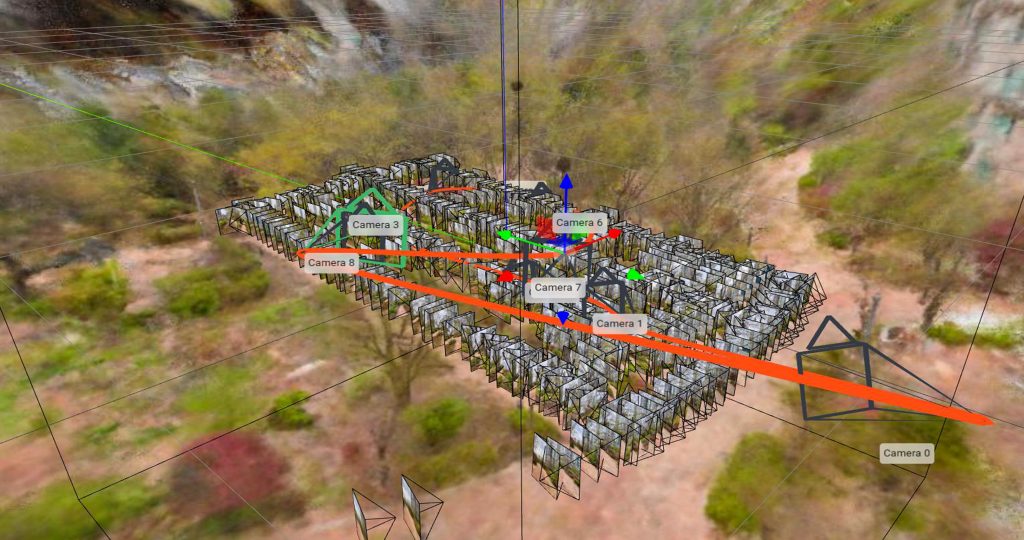

필자는 실사 기반 3D를 만들기 위해 RealityCapture 와 Metashape 2개의 툴을 사용하고 있으며, 이 2개의 도구는 오브젝트를 만들기에 적합합니다. 신경 방사 필드 NeRF(Neural Radiance Fields)는 3D 공간을 만들어내기에 더 적합한 것으로 보입니다.

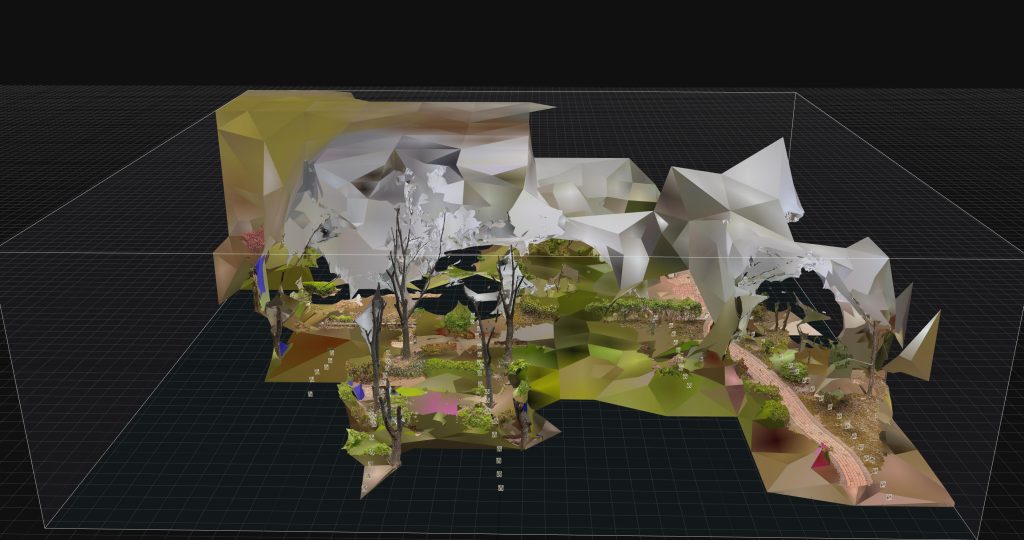

Metashape 와 RealityCapture 는 3D 객체를 만들기 위한 소프트웨어 도구입니다. 이 도구들은 주로 사진 측량(Photogrammetry) 기술을 사용하여 실제 객체를 3D로 변환시키는 작업을 수행합니다.

반면, NVlabs에서 제공하는 instant-ngp는 NeRF 기술을 사용하여 공간을 만들어 내는 도구입니다.

테스트에서는 이러한 도구들을 이용하여 여러 개의 샘플을 테스트해 보았고, 그 결과 신경 방사 필드 NeRF(Neural Radiance Fields)가 다른 도구들보다 더 우수한 공간을 만들어 낼 수있었습니다.

즉, NeRF(Neural Radiance Fields)는 사진 측량이나 3D 스캔보다 공간을 더 쉽고 정확하게 만들어 낼 수 있는 기술임을 보여줍니다.

- Case_001

샘플 이미지

카메라 위치

- Case_002

공간 및 오브젝트를 만들기 위해 가장 중요한 것은 촬영입니다. 좋은 결과물을 얻기 위한 전체 과정 중 촬영 부분이 70~80%의 영향을 미치기 때문입니다.

아래의 YouTube 영상은 스틸 사진을 촬영하여 공간을 만들고, 이를 역으로 360도 비디오로 만든 테스트 결과입니다. 아직 더 발전할 여지가 많지만, 목표했던 생각까지 결과물을 얻게 되어 뿌듯합니다.

최근 국내에서도 관련 자료들이 올라오고 있지만, 혼자서 공부하다 보니 많이 힘이 듭니다. ㅠㅠ

Nerf를 이용하여 스캔 후 360비디오 제작

다시 원점으로…;;

현재 시장에서 ‘제네시스 2023 G90 LWB의’ 경우 Object VR을 활용하여 제품의 내부와 외부를 자세히 살펴볼 수 있도록 제공하고 있습니다. Object VR은 3D 모델링이 아니지만 제품의 일부 각도와 세부 사항을 자세히 볼 수 있도록 해주는 기술입니다.

이를 통해 제품의 특징을 더욱 생생하게 전달하고 소비자들의 이해도를 높일 수 있습니다.

수 년전 다나와 사이트에서 적용한 사례가 있지만, 촬영 등 많은 작업과 비용이 필요하기 때문에 적용 범위가 제한적인 듯 현재는 운영하지 않고 있습니다.

아래 이미지는 ‘Ovject VR’을 적용한 제네시스 2023 G90 LWB사례이다.

신경 방사 필드 NeRF는 현재 매우 빠르게 발전하고 있는 기술 중 하나입니다. 이 기술을 활용하여 3D 모델링을 더욱 쉽고 정확하게 할 수 있게 됩니다.

예를 들어, 신경 방사 필드를 이용하여 실제 공간을 3D 모델로 만들 수 있어서, 가상의 제품을 시뮬레이션하거나 가상 현실과 같은 기술에서 매우 유용하게 사용될 것입니다.

또한,

기존에는 높은 비용과 어려운 접근성 때문에 사용이 제한적이었던 3D 모델링 기술이 이제는 보다 쉽게 사용될 수 있게 됩니다. 이는 다양한 산업 분야에서 혁신을 가져올 수 있을 것

입니다. 더불어, 다른 인공지능 기술과 함께 연계하여 더욱 발전할 가능성도 높아집니다.

instant-ngp는 이러한 신경 방사 필드 기술을 더욱 쉽게 사용할 수 있도록 도와주는 툴이므로, 3D 모델링에 관심이 있는 분들은 이를 활용하여 공부해볼 수 있습니다.

‘NVIDIA Instant NeRF 설치 튜토리얼‘ 을 2달 전 포스팅 했습니다. 공부를 하시고자 하시는 분은 참고하세요.